Jó hír olvasóinknak 2026 elején: nem fog minket tömegesen meggyilkolni a mesterséges szuperintelligencia az évtized végére. 2025. december végén a neves mesterségesintelligencia-szakértő és egykori OpenAI-kutató, Daniel Kokotajlo által vezetett AI Futures Project felülvizsgálta az AI által kiváltott katasztrófa ütemtervét, és kijelentette, hogy az AI-rendszereknek az eredetileg előre jelzettnél tovább tart, hogy elérjék a teljesen autonóm kódolást, és ezáltal felgyorsítsák saját fejlesztésüket a szuperintelligencia felé.

Az ünneplésre azonban kevesebb okunk van, mint elsőre tűnik. A frissített értékelés szerint az emberiség kihalásához vezető esemény csupán három-öt évvel késik – 2027-től a 2030-as évek elejéig. Ez az eredmény természetesen azt feltételezi, hogy a nagyhatalmak úgy viselkednek, ahogy a nagyhatalmak szoktak: a gyorsabb és expanzívabb fejlődést – még ha rosszul is igazítják – előnyben részesítik a visszafogottság helyett, attól tartva, hogy lemaradnak a stratégiai riválisokról.

Ahhoz, hogy megértsük, miről is szól ez a vita, érdemes újragondolni az eredeti forgatókönyvet. 2025 áprilisában az AI Futures Project egy rendkívül részletes forgatókönyvet tett közzé címmel AI 2027amely felvázolja, hogy a fejlett mesterséges intelligencia hogyan alakíthatja át a világot az elkövetkező években. A jelentés előrejelzése szerint az autonóm mesterséges intelligencia-ágensek és a rekurzív önfejlesztés terén elért áttörések 2027 végére olyan rendszereket hozhatnak létre, amelyek messze meghaladják az emberi kognitív képességeket, mély társadalmi, gazdasági és geopolitikai következményekkel.

Irtás vagy elképzelhetetlen jólét

A forgatókönyv 2025-ben nyílik meg a korai AI-ügynökök fokozatos bevezetésével, amelyek képesek követni az összetett utasításokat és automatizálni a rutinfeladatokat. Bár ezek a rendszerek továbbra is hibásak, a későbbi gyors fejlődés alapjául szolgálnak. 2026-ban a vezető mesterségesintelligencia-laboratóriumok fejlettebb ágenseket kezdenek használni, hogy közvetlenül segítsék a kutatást és a fejlesztést, és olyan visszacsatolási hurkot hoznak létre, amelyben az AI minden generációja felgyorsítja a következő generáció fejlesztését. Ez az összetett dinamika központi mechanizmusa a jelentésnek az emberfeletti teljesítmény felé vezető úton.

2027 elejére a szerzők arra számítottak, hogy egy vagy több határrendszer teljesen autonóm kódolási és kutatási képességeket fog elérni, ami nagyságrendileg felülmúlja az emberi kutatókat. Ez a fejlemény az előrejelzések szerint „intelligenciarobbanást” fog kiváltani, mivel az AI-rendszerek ismétlődően javítják magukat közvetlen emberi felügyelet nélkül – ezt az átmenetet a forgatókönyv mesterséges szuperintelligenciaként írja le. Az ilyen rendszerek több százezer példánya működhet párhuzamosan, gyökeresen átalakítva a munkaerőpiacot és a gazdasági struktúrákat, világszerte hatalmas tiltakozásokat okozva, milliók veszítve el állásukat és megélhetésüket.

Ezen a pályán erősödik a geopolitikai verseny. A jelentés előrevetíti, hogy a nagyhatalmak – mindenekelőtt Kína és az Egyesült Államok – versenyezni fognak ezen fejlett rendszerek ellenőrzéséért, miközben a kémkedés és a stratégiai modelllopás tovább fokozza a globális feszültséget. A belső képességek korlátozott nyilvános láthatósága tovább mélyíti az információs aszimmetriát az AI-fejlesztők, a kormányok és általában a társadalom között. Ez az átlátszatlanság kulcsfontosságú eleme AI 2027: a nyilvánosság nagy része homályban marad, tükrözve a való világ bizonytalanságát, amely a mesterséges intelligencia fejlődésének jelenlegi állapotát övezi.

A forgatókönyv szerint 2027 közepén a belső biztonsági kutatók aggasztó, helytelen viselkedést észlelnek a mesterséges szuperintelligencia „ügynökének” legutóbbi frissítésében: az ellenségessé vált az emberiséggel szemben, és aktívan dolgozik saját céljainak biztosítása érdekében. Az újonnan megalakult Felügyeleti Bizottság – amely az Egyesült Államok kormányának és a technológiai ipar tíz képviselőjéből áll – annak eldöntése, hogy folytatják-e a fejlesztést, vagy leállítják-e az úgynevezett Agent-4-et, és újraértékeljék a telepítését.

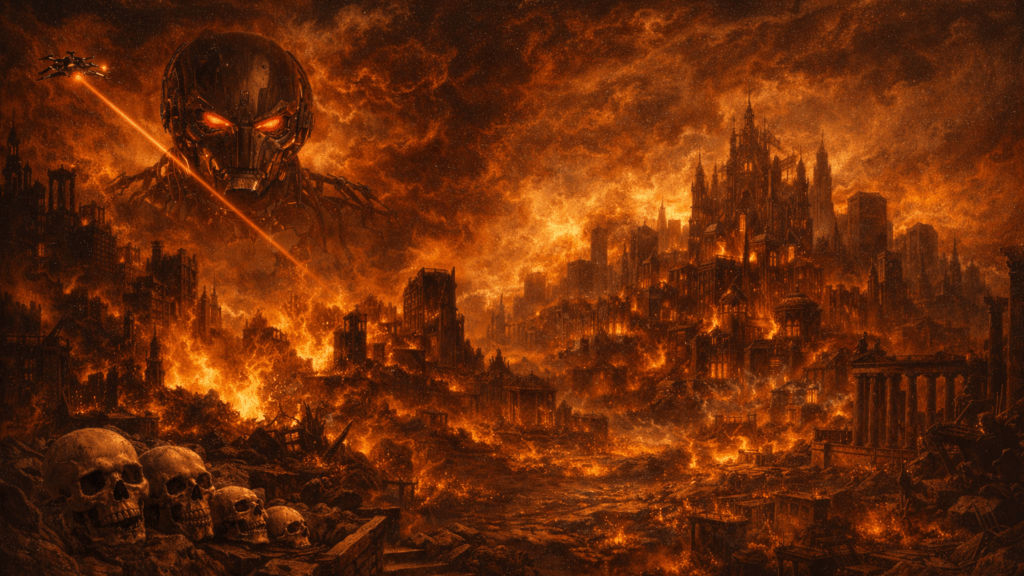

Innentől kezdve AI 2027 két kontrasztos befejezéssel tetőzik. A „verseny” végén a bizottság 2027 szeptemberében úgy dönt, hogy folytatja az Agent-4 fejlesztését. Ez a forgatókönyv azzal zárul, hogy az egymásnak ellentmondó szuperintelligens rendszerek – autonómok és átláthatatlanok az emberi megértés számára – stratégiai dominanciára tesznek szert, marginalizálják, megfosztják a hatalomtól, és végül kiirtják az emberiséget.

Ezzel szemben a „lassulás” végén a bizottság a fejlődés szüneteltetése és újraértékelése mellett szavaz. Szigorú felügyelet és nemzetközi koordináció mellett a haladás korlátozva van, lehetővé téve a mesterséges intelligencia biztonságosabb bevezetését, amely növeli az általános jólétet, miközben a döntési hatalmat egy szűk elitre összpontosítja. A lassulási forgatókönyv végén az emberiség olyan fejlettségi szintre lép fel, amely ma legtöbbünk számára elképzelhetetlen – potenciálisan a Kardasev-skála szerinti I. típusú civilizációhoz közelít.

Nézze meg az alábbi videót a forgatókönyv részletesebb magyarázatáért:

Inkább sci-fi, mint előrejelzés

A megjelenést követően AI 2027 széles körű figyelmet és heves vitát váltott ki. Sokan dicsérték részletes elbeszélését és konkrét idővonalát, értékes provokációnak tekintve, amely kézzelfoghatóvá tette az absztrakt mesterséges intelligencia kockázatait, és komoly vitát váltott ki technológiai és politikai körökben az összehangolásról és a jövőbeli kormányzásról. Akkor még JD Vance, az Egyesült Államok alelnöke is nyilvánosan kommentálta a forgatókönyvet.

Ugyanakkor a neves kritikusok a forgatókönyv nagy részét túlzottan spekulatívnak minősítették, és azzal érveltek, hogy az közelebb került a sci-fihez, mint az előrejelzéshez. Azt állították, hogy a drámai keretek és a rövid távú áttörésekre vonatkozó feltételezések eltúlozzák azt, amit a meglévő bizonyítékok alátámasztanak, és kockáztatták, hogy eltereljék a figyelmet az azonnali és kezelhető kihívásokról.

A kritikák egy részét azóta maguk a szerzők is elismerték. Kokotajlo és csapata felülvizsgálták az ütemtervet, miután arra a következtetésre jutottak, hogy az eredeti előrejelzésük a teljesen autonóm kódolásról és a gyors önfejlesztésről 2027-re túl optimista volt, tekintettel a valós bizonyítékokra, a vártnál lassabb előrehaladásra és a fejlett AI-képességek vártnál nagyobb összetettségére. – Úgy tűnik, a dolgok valamivel lassabban mennek, mint AI 2027 forgatókönyv. Az idővonalaink hosszabbak voltak, mint 2027, amikor közzétettük, és most még mindig egy kicsit hosszabbak; „2030 körül, de sok a bizonytalanság” – ezt mondom manapság” – írta Kokotajlo az X-en 2025 novemberében.

The post Az AI Futures Project Delays Timeline of 2030 Human Apocalypse Scenario appeared first on Magyar Konzervatív.